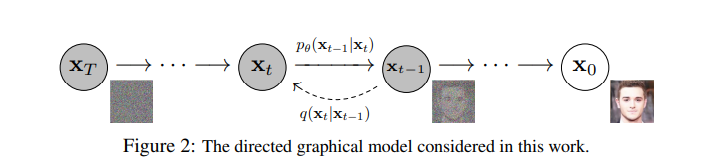

[Probabilistic Machine Learning]: Fundamentals-Optimization

优化问题通常可以表示为:

\[\theta^* \in \arg\min_{\theta \in

\Theta} L(\theta)\]

其中,\(\theta^*\)是优化得到的参数,\(\Theta\)是参数空间,可以是任意维度的实数集合,而\(L(\theta)\)是目标函数或损失函数,它衡量了参数与某种目标之间的距离。

凸优化问题的局部最优解即是全局最优解,而非凸问题可能有多个局部

![[Probabilistic Machine Learning]: Fundamentals-Optimization](/images/Fundamentals-Probability/0.png)

![[Probabilistic Machine Learning]: Fundamentals-Information theory](/images/Fundamentals-Information%20theory/0.png)

![[旅游日志] :青甘大环线](/images/%E9%9D%92%E7%94%98%E5%A4%A7%E7%8E%AF%E7%BA%BF/17.jpg)